L’évaluation en 8 questions

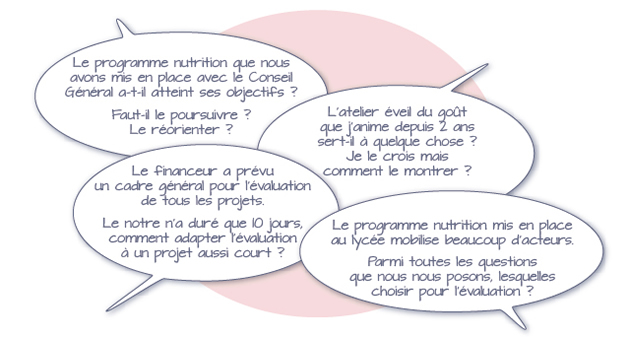

Evaluer paraît souvent compliqué, tant les enjeux sont importants et divers. C’est en effet difficile d’adapter l’évaluation au contexte de l’intervention. D’où l’importance des questions à se poser avant de démarrer :

Ces quelques exemples montrent que l’évaluation ne se résume pas à l’application de techniques ou d’outils. Préalablement, il convient de se poser les bonnes questions en fonction du contexte, en d’autres termes de fixer des objectifs à l’évaluation personnalisée de notre intervention.

Tout ne peut pas être évalué, sauf à y mettre des moyens importants, voire disproportionnés par rapport à l’intervention. L’évaluation est donc à dimensionner au regard de l’intervention.

L’évaluation est un procédé permettant d’acquérir des informations utiles à la prise de décision.

La prise de décision se caractérise par des interventions structurées à des niveaux différents, par exemple les actions, les programmes, les plans et les politiques. Logiquement, les politiques déterminent les plans, sur lesquels se construisent les programmes se traduisant par la mise en oeuvre d’actions sur le terrain. Les politiques se situent donc au sommet de la hiérarchie décisionnelle. Au fil de la descente dans les degrés de la pyramide, des politiques jusqu’aux actions, la nature de la prise de décision change, de même que la nature de l’évaluation requise. L’évaluation des politiques concerne des propositions ouvertes et un large éventail de scénarios. L’évaluation d’un programme comporte des méthodes plus normatives car les objectifs d’un programme sont plus précis que ceux d’une politique. Cette vision descendante de la chaîne de décisions n’est pas le modèle unique, mais elle est très fréquente.

Dans le cadre de ce guide, nous nous limitons à l’évaluation d’interventions, comprises comme des actions voire des programmes constitués d’une série d’actions coordonnées contributives à un programme.

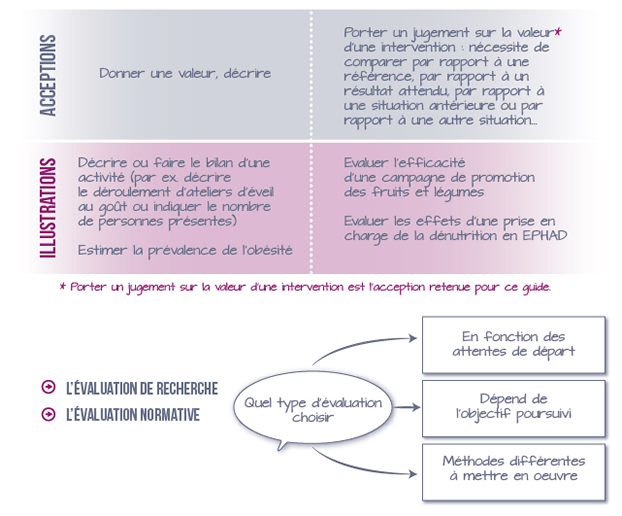

Le concept de l’évaluation a évolué. Historiquement, il s’agissait de mesurer puis de décrire l’activité (bilan), plus récemment de porter un jugement sur les réalisations (évaluation sommative) et maintenant, de plus en plus souvent, d’apporter un jugement au terme d’un processus d’accompagnement des promoteurs et de négociations sur des orientations à prendre (évaluation formative).

Schématiquement, le concept d’évaluation peut être compris dans deux acceptions :

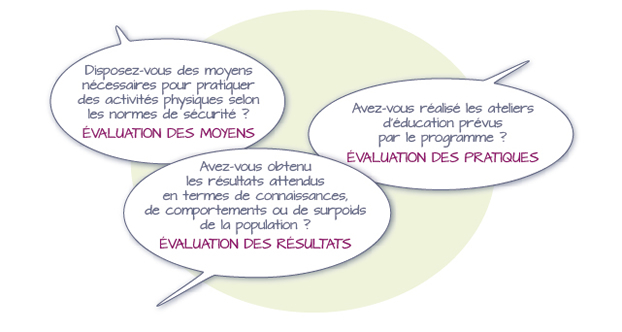

L’évaluation normative vérifie la réalisation et les résultats de l’intervention par rapport à des références fixées a priori. A titre d’illustration, voici le type de questions auxquelles elle permet de répondre.

NB : la terminologie n’est pas complètement stabilisée (l’évaluation normative est appelée également de performance ou pragmatique ou professionnelle).

En savoir plus

Le terme «normatif» fait référence à la comparaison des résultats obtenus à des normes ou références.

Le terme «performance» fait référence à la comparaison des résultats obtenus à des résultats attendus.

Le terme « pragmatique » fait référence à l’évaluation en situation réelle (à la différence d’expérimentale).

Le terme « professionnel » fait référence aux acteurs, souvent des professionnels plutôt que des chercheurs.

Ces termes différents recouvrent pratiquement un même concept et l’expression «évaluation normative» est retenue pour le présent guide.

Mais, dans de nombreux domaines, il n’existe pas de normes ou de références, il faut donc les créer entre professionnels concernés au moment de la préparation de l’évaluation.

L’évaluation des résultats par une évaluation normative a pour objet d’indiquer si les objectifs fixés ont été atteints, mais ne permet pas d’affirmer que le résultat est lié à l’intervention. Ainsi, la comparaison des résultats obtenus aux résultats attendus ne permet pas de conclure à un lien de causalité (car il manque un groupe témoin). C’est la différence avec une évaluation de recherche.

A titre d’illustration : si l’augmentation attendue du nombre de personnes se déplaçant à vélo dans une commune est obtenue, l’objectif est atteint. Mais, est-ce lié au programme éducatif nutrition mis en place par le service santé ou à l’aménagement de pistes cyclables réalisé dans le même temps par le service de la voirie dans une approche environnementale ?

En savoir plus

En termes de santé publique, l’essentiel est d’atteindre l’objectif.

En termes d’évaluation des stratégies, il est intéressant de connaître ce qui a conduit à cette évolution. La seule évaluation normative ne le permet pas. Une évaluation de recherche avec des comparaisons de stratégies permettrait d’y répondre de manière scientifique, mais cela demande une démarche longue, rigoureuse et contraignante, pas toujours adaptée à la réalité du terrain.

Cependant, par d’autres méthodes, on peut apporter des éléments de réponse à cette question. Par exemple, en réalisant une enquête a posteriori auprès de la population, complémentaire à l’évaluation normative, on peut obtenir des informations sur les comportements et les motifs de changement. Dans l’exemple ci-dessus, connaitre les motifs qui ont augmenté les déplacements à vélo.

L’évaluation de recherche en santé publique a souvent pour objet de mesurer si l’intervention a modifié, dans un sens favorable, la santé d’une population (ou dans un premier temps ses habitudes ou comportements). La méthode comparative entre un groupe d’individus soumis à l’intervention et un groupe d’individus non soumis à cette intervention est la plus reconnue sur le plan scientifique (épidémiologie analytique). Elle suppose de formaliser une question en amont de l’intervention et d’apporter ensuite la réponse par l’évaluation (ou une hypothèse de recherche à vérifier).

En savoir plus

A noter que les méthodes comparatives avant-après intervention, sans groupe témoin, ne permettent généralement pas de mesurer l’effet d’une intervention.

Par exemple, puisque l’indice de masse corporelle ou les connaissances évoluent naturellement avec l’âge, vouloir évaluer une intervention en comparant des résultats à un ou deux ans d’intervalle uniquement chez des enfants ou adolescents bénéficiaires du programme (qui ont donc grandi) n’a aucun sens pour évaluer une intervention.

Les 2 exemples de recherche ci-dessus illustrent quelques unes des contraintes et difficultés à prendre en compte avant de pouvoir répondre à ces questions évaluatives. Simplifier par manque de moyens, conduit inévitablement à un manque de rigueur méthodologique ne permettant pas de répondre aux questions évaluatives de départ. C’est donc de l’énergie engagée à perte.

Comment choisir entre une évaluation normative et une évaluation de recherche ?

Si l’objectif de l’évaluation est de chercher à améliorer une intervention, conçue par des acteurs, fonctionnant parfois depuis longtemps : évaluation normative. L’attention sera focalisée sur quelques aspects à améliorer et donc à évaluer (choix des questions évaluatives).

S’il y a une hypothèse à vérifier, une garantie de protocole strict, de respect des contraintes méthodologiques et un enjeu de santé : évaluation de recherche.

Les professionnels sont souvent intéressés par des questions nécessitant une approche de recherche, sans percevoir les contraintes. Mieux vaut donc clarifier au départ.

Si des actions locales peuvent entrer dans un programme de recherche, lorsqu’elles sont contributives d’un programme de recherche, elles ne peuvent généralement pas s’inscrire isolément dans une évaluation de recherche. Les contraintes méthodologiques de la recherche seraient disproportionnées par rapport à l’énergie disponible pour les actions locales.

Évaluer sert aux professionnels impliqués dans le management de l’intervention et permet :

- D’améliorer l’intervention en posant des questions préalables à sa réalisation permettant de préciser les objectifs et le processus

- D’apprécier de manière objective le travail réalisé

- D’intégrer ultérieurement l’expérience acquise et ainsi de progresser dans les pratiques professionnelles

- De transposer les modalités intéressantes de mise en œuvre de l’intervention dans d’autres lieux.

Évaluer sert à la population bénéficiaire et aux partenaires en leur permettant d’être informés de l’avancée et des résultats obtenus, de se voir proposer des interventions plus adaptées à leurs besoins, par exemple.

Évaluer sert aux financeurs, en rendant compte de l’utilisation des financements accordés, des résultats et de la pertinence des travaux ou de la nécessité de modifier à l’avenir les modalités d’intervention.

En référence à la charte de la Société Française de l’Evaluation (SFE), des principes sont à retenir pour les participants à l’évaluation :

- principe de pluralité : prendre en compte différents points de vue, de la conception de l’évaluation à la rédaction du rapport final.

- principe de distanciation : veiller à intégrer des personnes capables de prendre du recul, en particulier en évaluation interne, relever et signaler les conflits d’intérêt, vis-à-vis des promoteurs, des commanditaires ou autres.

- principe de respect des personnes : pas de transmission d’informations nominatives, sauf accord express des personnes concernées

- principe de transparence : règles claires définies au préalable de construction et d’utilisation du rapport d’évaluation, y compris de sa diffusion.

Dans le cadre d’une évaluation normative, il peut-être nécessaire d’interroger la CNIL sur des procédures ou de déclarer certains questionnaires, par exemple (recueil de données sensibles ou constitutions de fichiers…).

Dans le cadre d’une évaluation de recherche, il convient de respecter les règles d’autorisation liées aux protocoles de recherche.

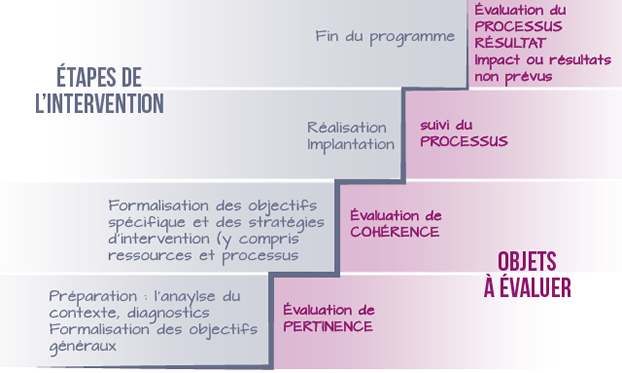

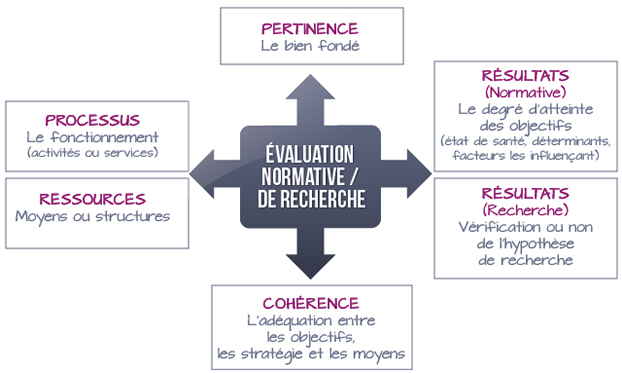

Différents objets de l’évaluation sont à distinguer et peuvent être positionnés en regard des composantes et des étapes d’une intervention. En effet, une intervention a plusieurs composantes :

- les objectifs : objectif général et spécifiques

- une organisation comprenant des structures (institutions porteuses du projet) et des ressources (humaines c’est à dire les acteurs, matérielles, financières)

- des processus : ce qui transforme, fait du lien entre structures et ressources en vue de la réalisation de l’intervention

- une production : des effets (résultats et impacts)

Parallèle entre les étapes de planification de l’intervention et les objets à évaluer.

Evaluer c’est analyser les relations entre les composantes de l’intervention :

- le contexte extérieur à l’intervention et les objectifs : pertinence

- les niveaux d’objectifs (objectif général et spécifiques) ou entre les objectifs et l’organisation : cohérence

- l’organisation prévue et l’organisation mise en place : évaluation communément appelée de processus s’appliquant en fait au processus au sens strict et aussi aux ressources et aux structures

- les objectifs et la production : évaluation de résultats ou encore d’efficacité potentielle ou réelle

En savoir plus

L’efficacité potentielle concerne les bénéficiaires de l’intervention

Exemple : les effets obtenus - pour les seuls élèves obèses qui ont répondu positivement au dépistage de l’obésité puis aux séances éducatives - mesurent l’efficacité potentielle

L’efficacité réelle concerne la population concernée au départ

Exemple : les effets obtenus pour tous les élèves obèses du lycée - qu’ils soient ou non venus au dépistage puis aux séances éducatives - mesurent l’efficacité réelle.

L’efficacité réelle prend donc en compte la participation au programme, important en termes de santé publique

- les objectifs, la production et les ressources : évaluation de l’efficience ou dans notre domaine évaluation médico-économique.

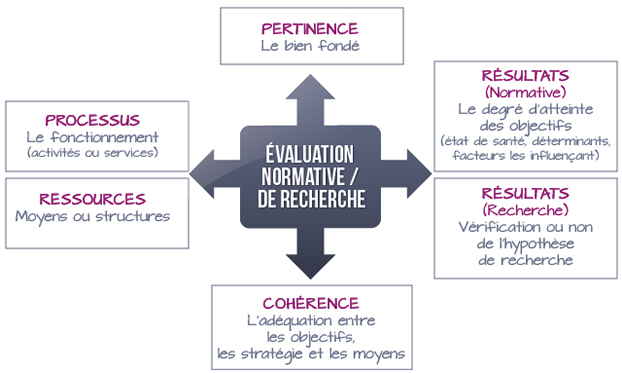

Evaluation de la pertinence

La pertinence interroge le bien-fondé du programme ou de l’intervention. Ce jugement peut être porté a priori lors de la phase de préparation d’une intervention et a posteriori (lors de l’évaluation finale en requestionnant le bien-fondé de l’intervention).

Evaluation de la cohérence

Ce type d’évaluation interroge la cohérence entre :

- les différents objectifs ;

- les objectifs et les stratégies d’intervention prévues pour atteindre les objectifs ;

- les stratégies d’intervention prévues et les moyens alloués (ressources).

Ce jugement peut être porté a priori pendant la phase de préparation d’une intervention et a posteriori (lors de l’évaluation finale en requestionnant le bien-fondé des modalités de l’intervention).

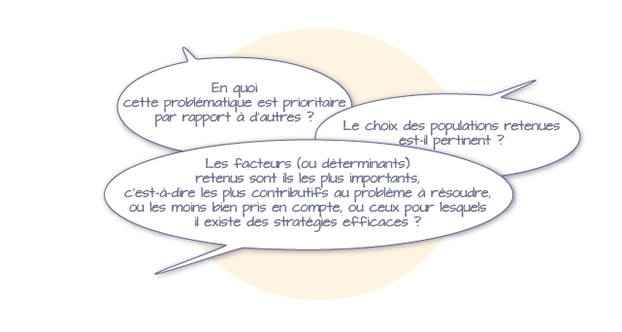

Evaluation des processus

L'évaluation de processus explore le fonctionnement du programme. Elle concerne les activités et services produits par le programme, les ressources mobilisées (humaines, matérielles et financières) et la participation des différents types d’acteurs (populations concernées, partenaires, intervenants, …).

En savoir plus

L'évaluation de processus permet au final de décrire et éventuellement de comprendre ce qui s'est passé sur le terrain et de savoir dans quelle mesure l'implantation de l’intervention a été conforme à ce qui était prévu. Elle peut-être réalisée en cours d’implantation permettant ainsi, si nécessaire, de rectifier l’organisation.

Schématiquement, deux éléments que sont la réalisation des activités et la participation des personnes peuvent être évalués et abordés en termes de quantité et de qualité. L’ajout de critères de satisfaction est également envisageable. Enfin, une évaluation des ressources peut-être réalisée en comparant les ressources allouées aux ressources prévues et les ressources utilisées aux ressources allouées.

- les objectifs, la production et les ressources : évaluation de l’efficience ou dans notre domaine évaluation médico-économique.

Evaluation de la pertinence

La pertinence interroge le bien-fondé du programme ou de l’intervention. Ce jugement peut être porté a priori lors de la phase de préparation d’une intervention et a posteriori (lors de l’évaluation finale en requestionnant le bien-fondé de l’intervention).

Evaluation de la cohérence

Ce type d’évaluation interroge la cohérence entre :

- les différents objectifs ;

- les objectifs et les stratégies d’intervention prévues pour atteindre les objectifs ;

- les stratégies d’intervention prévues et les moyens alloués (ressources).

Ce jugement peut être porté a priori pendant la phase de préparation d’une intervention et a posteriori (lors de l’évaluation finale en requestionnant le bien-fondé des modalités de l’intervention).

Evaluation des processus

L'évaluation de processus explore le fonctionnement du programme. Elle concerne les activités et services produits par le programme, les ressources mobilisées (humaines, matérielles et financières) et la participation des différents types d’acteurs (populations concernées, partenaires, intervenants, …).

En savoir plus

L'évaluation de processus permet au final de décrire et éventuellement de comprendre ce qui s'est passé sur le terrain et de savoir dans quelle mesure l'implantation de l’intervention a été conforme à ce qui était prévu. Elle peut-être réalisée en cours d’implantation permettant ainsi, si nécessaire, de rectifier l’organisation.

Schématiquement, deux éléments que sont la réalisation des activités et la participation des personnes peuvent être évalués et abordés en termes de quantité et de qualité. L’ajout de critères de satisfaction est également envisageable. Enfin, une évaluation des ressources peut-être réalisée en comparant les ressources allouées aux ressources prévues et les ressources utilisées aux ressources allouées.

Evaluation des résultats

L’évaluation de résultats consiste à mesurer le degré d’atteinte des objectifs annoncés. Selon les objectifs du programme, cela peut concerner des évolutions de l’environnement, des politiques de santé, des connaissances, représentations ou comportements individuels, des paramètres biologiques ou anthropométriques, des pathologies, …

Schématiquement, les objectifs peuvent être classés en termes de santé, en termes de déterminants de santé et en termes de facteurs influençant les déterminants de santé. Les résultats seront classés dans les mêmes catégories.

En savoir plus

L’outil de catégorisation des résultats, élaboré par Promotion Santé Suisse et présenté dans la partie « supports existants » illustre ce classement.

L’évaluation des résultats peut être éclairée par l’évaluation du processus.

En savoir plus

Par exemple, une faible participation aux activités proposées peut expliquer l’absence d’un changement attendu de comportement alimentaire. En complément, une évaluation compréhensive offre des clés pour comprendre. Dans l’exemple précédent, l’évaluation compréhensive par analyse du contexte et/ou enquête qualitative complémentaire permettra de connaître les motifs de la faible participation aux activités.

Les données recueillies lors de l’évaluation ou lors d’une enquête complémentaire ultérieure peuvent mettre en évidence des résultats inattendus (évaluation de l’impact).

L’évaluation dite stratégique

Cette évaluation aide à la planification et à l’élaboration de l’intervention, elle est plutôt réservée aux politiques et aux programmes d’envergure nationale ou régionale. Il s’agit en fait d’un diagnostic de situation, terme plus souvent utilisé dans le champ de la santé. Cette évaluation réalisée en amont de l’intervention (avant le début du projet) permet de juger de sa pertinence et de sa cohérence.

L’évaluation dite formative

Cette évaluation contribue à l’accompagnement des équipes et fournit de l’information en cours de route pour améliorer une intervention. Il s’agit de mettre en place des tableaux de bord pour assurer un suivi du processus. Si une dérive est constatée, soit le processus est corrigé pour se rapprocher de ce qui était prévu, soit l’objectif et le processus sont modifiés car considérés en l’état comme inatteignables. Cette évaluation se prépare en même temps que se prépare l’intervention, elle comporte des étapes intermédiaires (en cours d’intervention) et une étape finale (après l’intervention).

L’évaluation dite sommative

Cette évaluation a comme objet de déterminer les effets produits par l’intervention. Dans ce cas, l’évaluation n’interfère pas sur les objectifs ou le processus et il n’y a généralement pas d’analyse intermédiaire des résultats avant la fin de l’intervention. Cette évaluation se prépare en même temps que se prépare l’intervention, elle nécessite souvent d’engranger des données en cours d’intervention en vue d’une évaluation finale. Elle est plutôt utilisée en recherche pour mesurer l’efficacité et l’efficience d’une intervention.

Bien distinguer quand évaluer et quand préparer l’évaluation : en effet, l’évaluation se prépare au moment où se prépare l’intervention, se déroule pendant et après l’intervention. Mais, à chaque étape de l’intervention, l’évaluation répond à une finalité différente et complémentaire

Les 3 étapes de l’évaluation

3 étapes pour 3 finalités d’évaluation

Etape 1 : Evaluation stratégique (lors de la préparation de l’intervention) => une phase essentielle

Cette analyse préliminaire ou évaluation « a priori » vérifie que la thématique et les objectifs affichés sont bien choisis, compte tenu du contexte sanitaire, environnemental, politique et des diagnostics réalisés. Ceci évalue la pertinence de l’intervention.

Ensuite, l’analyse préliminaire vérifie que les stratégies prévues sont cohérentes pour atteindre les objectifs affichés..

Etape 2 : Evaluation formative (évaluation pendant l’intervention, évaluation dite souvent intermédiaire)

- conseillée

- vérifie la dynamique du déroulement de l’action, mesure l’adéquation des moyens et des ressources, recentre l’action sur les objectifs initiaux

- permet aux promoteurs d’ajuster si besoin

Exemples de questions évaluatives : il s’agit essentiellement d’évaluer le processus

Etape 3 : Evaluation finale (après l’intervention, concerne l’évaluation formative et sommative)

- évalue la production (résultats et impact), les effets et les conditions de réalisation (processus mis en œuvre)

Exemples de questions évaluatives :

- L’intervention a-t-elle évolué par rapport au plan initial ? Il s’agit d’évaluer le processus en fin de programme.

- L’action atteint-elle ses objectifs ? Il s’agit d’évaluer les résultats.

- L’intervention a-t-elle eu des effets non prévus (positifs et négatifs) ? Il s’agit d’évaluer l’impact.

L’évaluation est-elle réalisée en interne par l’équipe qui anime l’intervention (auto-évaluation), par une équipe externe, ou de manière mixte ? Cela dépend des finalités de l’évaluation.

Une évaluation formative peut se faire en interne, avec éventuellement un apport externe (mixte). Une évaluation sommative se fait généralement par une équipe externe, en organisant des contacts avec l’équipe chargée de l’intervention.

De toutes les façons, si un regard externe est toujours à rechercher, une évaluation, au moins dans sa phase de conception doit être préparée avec l’équipe chargée de l’intervention et si possible avec des représentants des personnes concernées par l’intervention : les bénéficiaires.

Une évaluation est nécessairement collective.

Des ressources / supports documentaires existants

Ce guide est destiné aux organismes réalisant des études dans le champ de la nutrition, aux responsables régionaux de la santé publique et, de façon plus large, aux membres des conférences régionales de santé, aux acteurs de santé impliqués dans le domaine de la nutrition et aux élus des collectivités territoriales. Ce guide propose, sous forme de fiches thématiques, des méthodes et des références pour la réalisation d’études en lien avec le PNNS.

Cet ouvrage est applicable aux domaines de la santé et du secteur social. Vous pourrez y trouver une présentation globale et conceptuelle (avec quelques exemples) de la démarche d’évaluation, déclinée en 9 étapes.

- Institut National de Prévention et d’Education pour la Santé (INPES). Evaluation, mode d’emploi. 2005.

- Instance Régionale d'Education et de Promotion à la santé (IREPS). Evaluer vos actions en éducation et promotion à la santé. Octobre 2011.

Deux guides d'accompagnement visant l’évaluation d’actions en prévention et en éducation pour la santé, illustrés par des exemples, questions, articles ou extraits d’ouvrage.

Il s’agit d’un outil permettant l’analyse systématique des résultats d’un projet selon un système de catégories déclinées en 4 colonnes distinctes : amélioration de la santé de la population, modifications des déterminants de la santé, modifications des facteurs influençant les déterminants de la santé, activités de promotion de la santé.

L’outil Preffi 2.0 est applicable aux différents types de projets en promotion de la santé. Il s’agit d’un outil de pilotage et d’analyse de la planification, reposant sur un formulaire de notation défini. Les indicateurs déclinés sont des indicateurs prévisionnels de la qualité de la planification.

Ce guide d’auto-évaluation a été créé pour les actions en promotion de la santé menées par les associations. Le thème principal est d’améliorer la qualité des actions, combinant plusieurs approches (participative, volontaire, formative, facilitée). Il peut être un complément dans vos démarches d’évaluation et d’amélioration.

Ce guide est composé de quatre parties et présente d’abord l’étude ICAPS (Intervention auprès des Collégiens centrée sur l’Activité Physique et la Sédentarité). La deuxième partie décrit la mise en place d’un projet de type ICAPS (dont l’évaluation). Les troisième et quatrième parties proposent des outils d’aide à la mise en œuvre et des définitions.

Ce guide a pour objectif d’aider les acteurs à s’interroger sur les objectifs qu’ils souhaitent donner à leur auto-évaluation dans les démarches communautaires en santé. Cet outil allie éléments méthodologiques et des outils prêts à être complétés pour construire votre propre démarche d'auto-évaluation.

Ce guide d'évaluation a pour objectif d'aider les personnes qui mettent en œuvre des mesures de promotion de la santé dans les domaines de l’alimentation, de l’activité physique et de la santé psychique à destination des groupes cibles des enfants, des adolescent·e·s et des personnes âgées. Un projet fictif est utilisé comme fil conducteur tout au long de ce guide avec des explications théoriques et des exercices sur le thème du modèle d’impact et du concept d’évaluation.

Le suivi, la surveillance (le monitoring) consistant à relever des informations sans les comparer ne sont pas de l’évaluation, même s’ils peuvent y contribuer. L’appréciation est faite lors de la comparaison de ces informations à une référence ou à un groupe témoin. L’évaluation est une démarche d’observation et de comparaison : ainsi… une même information recueillie peut servir à la fois à la surveillance et à l’évaluation.

La démarche qualité (et l’audit, une des méthodes utilisées en démarche qualité) est souvent comparée à l’évaluation normative (ou de performance). Ces concepts sont proches mais cependant différents. La démarche qualité s’applique uniquement aux processus. L’évaluation normative peut s’appliquer aux processus et aux résultats.

La qualité est une notion relative, car elle est fonction des exigences des parties prenantes c'est-à-dire des producteurs et des utilisateurs du service ou du produit. Le niveau de qualité optimal ne devant pas produire de coût inadéquat (sur-qualité) qui pourrait rendre le service inaccessible au plus grand nombre. En santé publique, la qualité doit donc inclure non seulement la prestation en elle-même mais aussi son environnement (l’accessibilité en fait partie).

Les sociétés savantes et la Haute Autorité de Santé, notamment, produisent des recommandations de bonnes pratiques. Ces recommandations peuvent se décliner en référentiels permettant de définir, à un moment donné, ce qui est considéré comme une démarche de qualité.

Quand il n’y a pas de référentiel ou de normes, des références spécifiques doivent être créées. Ainsi, dans une intervention en promotion de la santé, le processus opérationnel de l’intervention est défini (processus attendu : par ex. type de séances éducatives, envoi d’informations, …) et le déroulement est examiné pour permettre de rendre compte s’il est réalisé selon le processus prévu. Sinon, des préconisations et des améliorations sont proposées. Cela se rapproche donc de l’audit dans une démarche qualité.